日々なにかと話題にあがるAI技術。今や「音声クローンが3秒で生成できる」と言われているが、その音声クローンを悪用した詐欺が世界中で横行しているという。人の声(声紋)は生体認証として個人を特定できるほどの特徴を持ち、声を通じて信頼関係が確約されているケースもあるが、その信用を揺るがしかねない事態に発展する可能性もある。

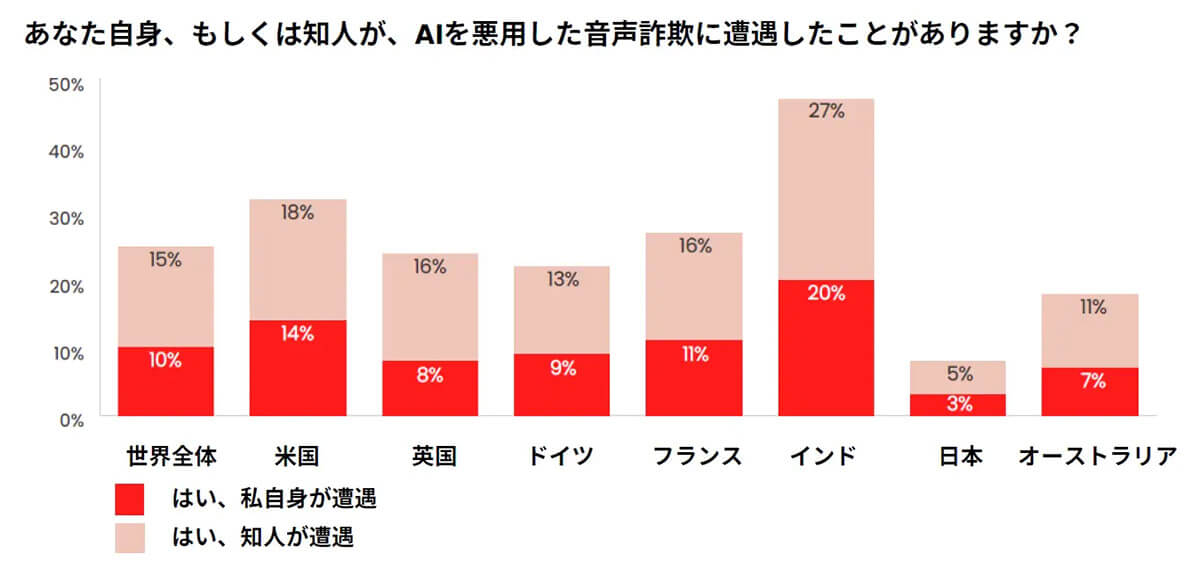

音声詐欺に遭遇したことがある人は世界で10%に

オンラインセキュリティ大手・マカフィーは17日、日本を含む世界7カ国(日本、米国、英国、ドイツ、フランス、インド、オーストラリア)を対象に実施したAI(人工知能)を悪用したオンライン音声詐欺の現状に関するレポート「The Artificial Imposter」を発表した。当該7か国の18歳以上の成人7,054人を対象に調査を行ったところ、「自身がAI音声詐欺に遭遇した」と回答した人が10%、「知人がAI音声詐欺に遭遇した」と回答した人が15%だった。日本での音声詐欺の遭遇率は世界7カ国で最も低く、「自身が遭遇」が3%、「知人が遭遇」は5%だった。この数字は、世界の平均の約3分の1だった。

精度が上がる音声クローニングを悪用した詐欺が横行

AIを悪用した「音声クローニング詐欺」は、ますます増加する可能性がある。音声クローニングとは、ターゲットとなる人物の音声からAIを用いて音声クローンを生成して、まるで「その人物が実際に発言しているかのようなデータを作り出す」ことができる技術のこと。インターネット掲示板では、すでに、著名人の音声を合成して作成された陰謀論や、誤情報が錯綜するなど悪用の危険性を指摘する声もあった。技術が身近になれば利便性が増すが、一方で、犯罪に使われるケースも増えかねない。

同社によると、詐欺師はAI技術を使って声のクローンを作り、困窮を偽ったボイスメールを送ったり、被害者の連絡先に電話をかけたりしていることが明らかに。回答者の70%(「識別できるかどうかわからない(35%)」と「識別できないと思う(35%)」の計)が、クローン音声と本物の識別に自信がないと回答しており、音声クローニングによる詐欺が勢いを増す要因にもなっているという。

このような詐欺から身を守るため、同社は「口頭でパスワード(合言葉)を確認する」「発信者への懸念」「クリックや音声シェアは慎重に」「個人情報保護サービスの管理」などと対策を呼びかけている。

出典元:【マカフィー株式会社/PR TIMES】